颠覆传统的科学,出人意料的2024诺贝尔物理学奖!

科学热点:

当地时间10月8日,瑞典皇家科学院宣布将2024年诺贝尔物理学奖授予科学家约翰·J·霍普菲尔德(John J. Hopfield)和图灵奖得主、“AI教父”杰弗里·E·辛顿(Geoffrey E. Hinton),表彰他们在使用人工神经网络进行机器学习的基础性发现和发明。今年诺贝尔物理学奖表彰的成果竟属于AI领域,人工智能已然成为颠覆传统的科学。

两位科学家的贡献

两位获奖者从20世纪80年代起就开展了与物理学相关的人工神经网络的重要工作。两人使用物理学工具开发了今天机器学习技术的基础方法。

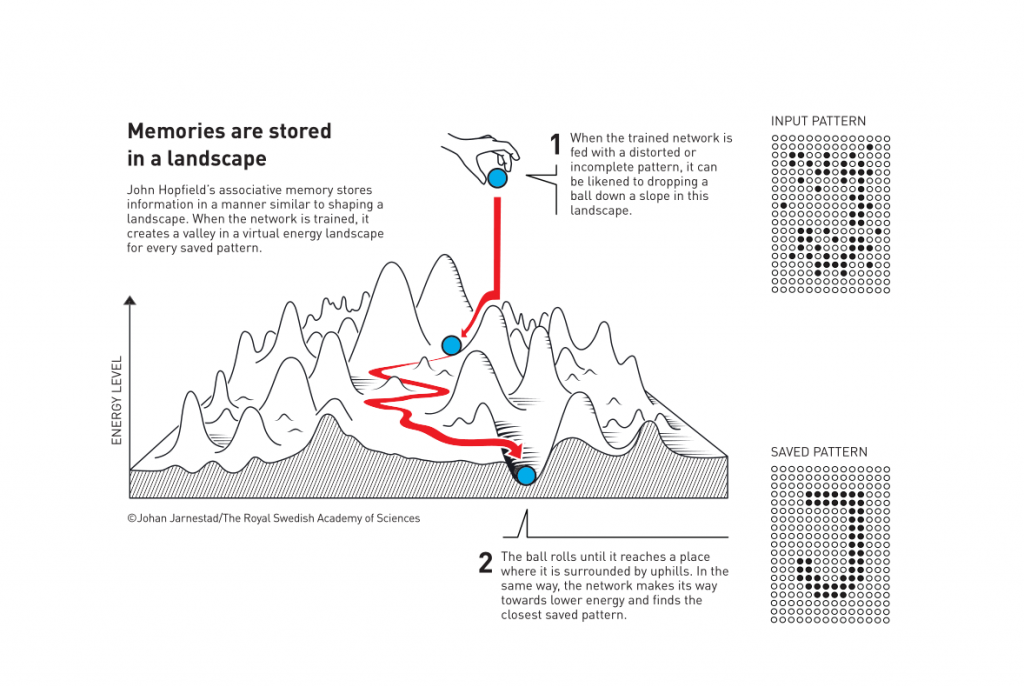

约翰·J·霍普菲尔德创造了一种关联记忆,它能够存储和重构图像以及其他模式类型。

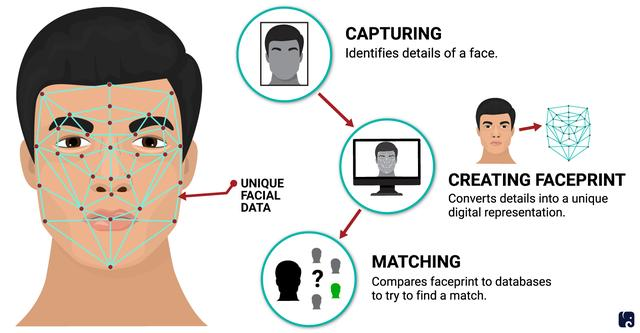

杰弗里·E·辛顿发明了一种能够自主发现数据中属性的方法,并执行任务,如识别图像中的特定元素。

辛顿将霍普菲尔德网络的想法应用于一种新网络,这种新网络使用另一种方法:玻尔兹曼机。玻尔兹曼机可以学习给定数据类型的特征元素,可以用来分类图像或创建新材料。这种机器学习帮助推动了当今机器学习的快速发展。

诺贝尔物理委员会主席埃伦·蒙斯表示,“获奖者的工作已经产生了巨大的效益。在物理学领域,我们将人工神经网络应用于广泛的领域,例如开发具有特定属性的新材料。”

关键词学习:人工神经网络

在人工智能的实践中,物理学家利用物理学工具构建新方法,为强大的机器学习奠定了基础。

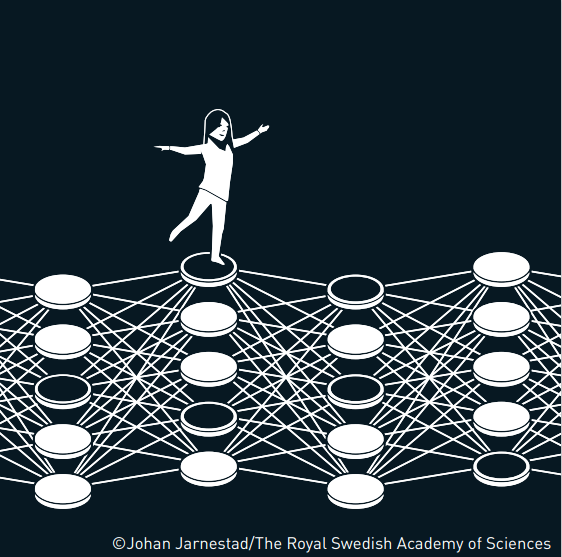

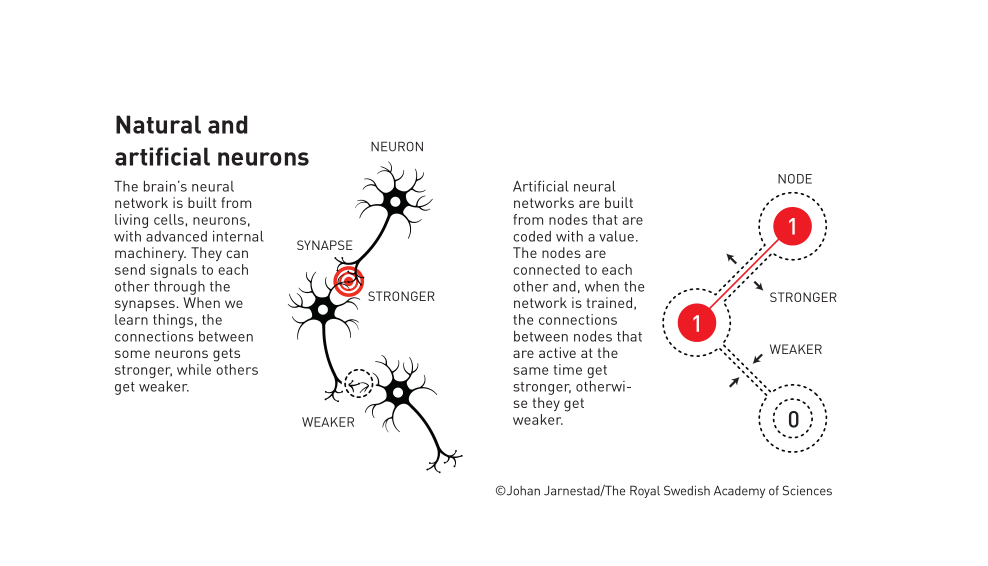

当我们谈论人工智能时,通常指的是使用人工神经网络的机器学习。而这项技术最初是受到大脑结构的启发。在人工神经网络中,大脑的神经元由具有不同值的节点表示。这些节点通过可以比作突触的连接相互影响,并且可以变得更强或更弱。网络由此实现训练。通过在同时具有高值的节点之间建立更强的连接。(摘自诺贝尔奖委员会官网)

使用人工神经网络的机器学习,也算到物理领域当中吗?

人工神经网络是一种模仿人脑结构和功能的计算模型,用于处理和解决复杂的问题。它由大量的神经元(节点)相互连接组成,每个神经元代表一种特定的输出函数。这些神经元通过调整连接权重来学习和适应不同的输入模式,从而能够进行分类、识别和预测等多种任务。

人工神经网络就像一个复杂的“大脑”,可以通过不断的学习和训练来提高自己的性能。

人工神经网络基本特征

非线性: 非线性关系是自然界的普遍特性。大脑的智慧就是一种非线性现象。人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系。具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量。

非局限性-联想记忆:一个神经网络通常由多个神经元广泛连接而成。一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定。

非常定性-自组织、自适应、自学习能力:神经网络不但处理的信息可以有各种变化,而且在处理信息的同时,非线性动力系统本身也在不断变化。经常采用迭代过程描写动力系统的演化过程。

非凸性:一个系统的演化方向,在一定条件下将取决于某个特定的状态函数。例如能量函数,它的极值相应于系统比较稳定的状态。非凸性是指这种函数有多个极值,故系统具有多个较稳定的平衡态,这将导致系统演化的多样性。沿着梯度方向进行优化只能保证找到局部最优解,而不是全局最优解。

应用领域

应用在日常生活中包括常见的图像识别、语音识别、自然语言处理,例如文本分类、情感分析、机器翻译。还能进行金融预测,医疗诊断,疾病诊断、医学影像分析等。在工业上可应用于机器人控制、智能制造等。

用物理解码信息

2024诺贝尔物理学奖授予的两位科学家所研究的开创性成果超越了传统物理学范畴,将物理学中的核心概念应用于神经网络的设计和训练中,推动了人工智能技术的革新。

革命性的跨越学科的融合,正是为其他科学领域的研究者提供了新的研究视角和方法,为人工智能开辟了新的天地!

资料来源:央视新闻、诺贝尔委员会新闻稿、百度百科

声明:本网站发布的部分图文素材等来源于第三方或网络信息,本文仅用于公益科普,版权归原作者或机构所有,内容如有侵权,请及时联系本网站删除。